| |

| Med Sci (Paris). 2013 May; 29: 16–25. Published online 2013 June 7. doi: 10.1051/medsci/201329s205.Un siècle de biologie de synthèse Luis Campos1* 1History Department, University of New Mexico, Albuquerque, NM 87131-1181États-Unis MeSH keywords: Congrès comme sujet, histoire, Prévision, Histoire du 17ème siècle, Histoire du 18ème siècle, Histoire du 19ème siècle, Histoire du 20ème siècle, Histoire du 21ème siècle, La médecine dans la littérature, Organismes génétiquement modifiés, Opinion publique, Recherche, Changement social, Distance sociale, Biologie synthétique, éthique |

« Tout est possible, et rien n’est certain »

Notre propos aujourd’hui ne porte pas sur la vie comme elle existe, mais sur la vie comme elle pourrait exister, c’est-à-dire sur la discipline nouvelle qu’est la biologie de synthèse par rapport à ce que la nature a déjà développé. L’idée peut paraître nouvelle ou révolutionnaire, mais elle s’inscrit en réalité, pour un historien comme moi, dans une tradition beaucoup plus ancienne. Si le champ actuel de la biologie de synthèse n’est âgé que d’une dizaine d’années, nous fêtons cette année le centième anniversaire de l’expression elle-même (Figure 1).

| Figure 1.

100e anniversaire de la « biologie synthétique ».

|

|

Les prémices de la biologie de synthèse : un dépassement du naturel ? Ma présentation décrira l’histoire de la biologie de synthèse de sa « préhistoire » jusqu’à aujourd’hui, cette approche du vivant qui dépasse le naturel et la nature pour répondre aux desseins de l’homme. L’histoire remonte aux premières observations, par exemple la pollinisation des plantes par les Assyriens. Plus récemment, quelques-unes des plus ingénieuses théories sur l’hérédité et l’hybridation des plantes ont été exposées ici, à Paris, sous les Lumières. Réaumur (René-Antoine Ferchault de Réaumur, 1683-1757) (Figure 2) proposait ainsi le croisement d’espèces différentes pour produire de nouvelles formes de vie aux caractéristiques utiles pour l’homme ; il pensait parvenir à créer des poules à poils et des lapins à plumes. Maupertuis (Pierre Louis Moreau de Maupertuis, 1698-1759) (Figure 2) prédisait que ces unions produiraient une grande quantité de monstres - de nouveaux animaux et peut-être même de nouvelles espèces que la nature n’avait pas encore engendrées.

| Figure 2.

Galerie de portraits des inventeurs de la biologie de synthèse.

|

Un peu plus de 150 ans plus tard, aux alentours de 1900, le célèbre zoologiste Yves Delage (1854-1920) (Figure 2) déclarait qu’en matière d’hérédité, tout était possible mais que rien n’était certain. Cette phrase est sans doute une bonne description de la biologie de synthèse actuelle. L’idée d’une approche du vivant ingénieuriale est un thème majeur et récurrent de l’histoire de la biologie au cours de ces derniers siècles, des débuts de la génétique classique à nos jours. Le croisement expérimental des plantes et des animaux connut des avancées significatives à la fin du XIXe siècle. Des horticulteurs talentueux comme Luther Burbank (1849-1926) (Figure 2) en Californie s’attachèrent dans les années 1880 à créer de nouvelles plantes, fleurs et fruits qui surpassent la nature au bénéfice de l’homme : des mûres blanches, des cactus sans épines, un nouveau type de marguerite, des fruits plus vigoureux et plus sucrés. Burbank pensait que l’homme pouvait « faire mieux que la nature » et accomplir en dix ans ce que la nature met dix siècles à produire. Il s’efforça donc de concevoir de nouvelles plantes grâce à une sélection minutieuse. Selon lui, un croisement réussi devait se mener comme une construction architecturale - sur la base de plans précis, avec intelligence et clairvoyance. Ses tentatives pour créer de nouvelles formes de vie ne furent pas toujours bien reçues. Dès les années 1890, des chrétiens de la région s’offusquèrent de ce que Burbank parle de « nouvelles créations » dans son catalogue : ils craignaient que ces nouvelles méthodes ne reviennent à « jouer à Dieu ». Le public réserva néanmoins un accueil enthousiaste à ses nouveaux fruits et fleurs, au point que Burbank connut rapidement une grande célébrité, qu’il fut surnommé le « magicien des plantes » et que des scientifiques européens voyagèrent jusqu’en Californie pour le rencontrer. Il n’existait pas alors de distinction claire entre création et ingénierie, mais on se référait à ces travaux d’hybridation comme à une sorte de synthèse : il s’agissait de synthétiser de nouvelles espèces. Le célèbre botaniste néerlandais Hugo de Vries (1848-1935) (Figure 2) fut l’un de ces scientifiques qui eut vent des travaux de Burbank et vint le visiter en Californie. De Vries apprécia Burbank, mais resta peu impressionné par ses qualités scientifiques : ce n’était après tout qu’un horticulteur croisant les espèces. De Vries avait ses propres théories sur les expériences à mener pour acquérir la maîtrise de l’évolution : là où Burbank croisait les espèces, il avait l’ambition d’en créer de nouvelles. De Vries avait travaillé pendant des années sur une nouvelle théorie des mutations, mot qu’il a d’ailleurs inventé, pour expliquer l’apparition soudaine de nouvelles espèces en l’espace d’une génération. Son étude des mutations naturelles de l’œnothère1 se combina à son intérêt pour la création artificielle de nouvelles espèces : selon ses termes, « l’évolution doit devenir une science expérimentale, qui doit d’abord être contrôlée, étudiée, puis conduite et finalement façonnée pour l’usage de l’homme. » Cette distinction entre le vivant tel qu’il est et tel qu’il pourrait être, cette scission entre le naturel et l’artificiel, semble avoir été une composante de la biologie au début du XXe siècle. De Vries était alors une figure majeure de la discipline : il avait redécouvert, avec d’autres, les travaux de Gregor Mendel, et sa théorie de la mutation, bien que complexe, eut une influence significative sur bien des chercheurs européens et surtout américains. Son intérêt pour l’évolution envisagée comme une science expérimentale le fit inviter en 1904 à l’inauguration d’un nouveau laboratoire, la station pour l’évolution expérimentale à Cold Spring Harbor (CSHL), New York. Le CSHL, qui est aujourd’hui l’un des principaux laboratoires de biologie moléculaire, fut d’abord un ensemble de jardins et de laboratoires dédiés aux travaux de génétique des plantes et des animaux. Selon les journaux de l’époque, les chercheurs du laboratoire étaient capables de modifier et améliorer les animaux et les plantes à volonté grâce à de nouvelles techniques de croisement, des rayons X et du radium : l’homme pouvait ainsi apprendre à être un créateur. Le premier directeur du laboratoire déclara même que la connaissance des principes de l’évolution permettait de modifier les organismes conformément à nos idéaux de beauté, d’appétence, de robustesse et de pouvoir. Le CSHL n’est que l’une des nombreuses institutions qui émergèrent à cette époque, et dont la fonction était de percer les lois de l’hérédité pour concevoir et reconcevoir la vie. Un journal de l’époque résume ainsi dans un article sensationnaliste les travaux du CSHL : donner des doigts de pied aux hamsters, changer la couleur des insectes peut conduire à l’émergence de surhommes. |

Biologie de synthèse au début du XX e siècle : Le « jardin chimique » de J. Loeb et S. Leduc D’autres scientifiques de l’époque ne s’intéressaient pas tant aux croisements ou à l’évolution qu’à la compréhension des mécanismes physiologiques de base du vivant. L’Américain d’origine allemande Jacques Loeb (1859-1924) (Figure 2) était célèbre pour son étude mécaniste des instincts et tropismes, ainsi que pour sa découverte largement saluée en 1899 de la parthénogenèse artificielle chez l’oursin, découverte considérée à ce moment là comme « la plus vitale dans l’histoire de la physiologie », pour ainsi dire presque « la fabrication de la vie en laboratoire. » Le titre de son ouvrage, Conception mécaniste de la vie

2, s’entend comme un jeu de mots. Loeb était parvenu à provoquer le développement embryonnaire d’œufs d’oursin non fécondés en modifiant la concentration de sel dans la solution où les œufs étaient maintenus : des larves pouvaient naître sans père. Les archives de l’époque regorgent de courriers inquiets de jeunes femmes célibataires, demandant si elles pouvaient se baigner dans la mer sans risque de tomber enceintes. Pour Loeb, la compréhension approfondie du phénomène impliquait de le maîtriser. La preuve ultime de contrôle sur la vie était donc non seulement de la manipuler à sa guise, mais finalement de pouvoir la recréer soi-même dans un tube à essai. Ses déclarations ne visaient pas à choquer, mais étaient la conséquence logique de son approche ingénieuriale de la vie. Les écrits de Loeb contiennent de nombreuses citations allant dans ce sens. Selon lui, les mécanismes de la vie étaient de nature chimique, et le jour était proche où les scientifiques manipulant des produits chimiques dans un tube à essai les verraient « s’unir pour former une substance capable de vivre, se mouvoir et se reproduire ». « Il est possible de placer sous notre contrôle le phénomène de la vie. Un tel contrôle est l’unique but de la biologie. » Loeb pensait que l’homme serait capable un jour de produire à volonté de nouvelles formes de vie, et que la tâche fondamentale de la physiologie était de produire artificiellement de la matière vivante. Il parle ainsi de « technologie de la substance vivante » et, ailleurs, de la nécessité d’une « biologie constructive ou ingénieuriale, au lieu d’une biologie simplement analytique ». C’était ainsi que l’on se représentait la biologie du futur au début du xxe siècle, vers 1912. D’autres biologistes accordaient moins d’importance à l’idée de contrôle mais se concentraient sur la production en éprouvette de formes proches de la vie pour mieux comprendre les mécanismes du vivant. Stéphane Leduc (1853-1939) (Figure 2), professeur de médecine à Nantes, utilisait des produits chimiques et les forces osmotiques dans ce qu’il appelait un « jardin chimique » pour produire des formes proches selon lui de la vie organique, bien qu’elles ne soient pas vivantes à proprement parler. Ces « analogues physiques » de processus biologiques menèrent Leduc à concevoir la « biologie synthétique » dès 1912. Le nom, les idées et certaines des pratiques et buts de la biologie de synthèse étaient donc déjà en place à cette époque. Dans les années 1920 et 1930, le radium et les rayons X furent employés pour créer des organismes mutants, plantes et animaux, dans l’espoir que certains d’entre eux s’avèrent utiles. Le deuxième directeur de Cold Spring Harbor, Albert Blakeslee (Figure 2), travailla sur le datura officinal (Datura stramonium) pendant des années avant de découvrir qu’il pouvait obtenir des individus mutants si remarquablement différents dans leurs caractéristiques de la plante normale qu’ils semblaient pour ainsi dire « produits sur commande, conformément à un plan et une volonté précis ». Il n’était donc plus nécessaire d’attendre pendant des lustres l’hybridation accidentelle de deux espèces et le doublement spontané et rare de leurs chromosomes pour obtenir des variétés supérieures. Certaines des formes qu’il avait créées méritaient selon lui d’être qualifiées de « nouvelles espèces synthétiques ». Ces résultats puissants et robustes étaient fondés sur le concept de « modularité chromosomique ». Ses contemporains saluèrent ses découvertes comme représentant l’ingénierie évolutionnaire que De Vries avait pressentie. Certains parlèrent même de « génie génétique », première occurrence de ce terme. Blakeslee poursuivit ses travaux, utilisant des substances comme la colchicine pour induire des mutations et créer par exemple des fleurs plus grandes, aux couleurs plus vives. Dans les années 1940 et 1950 apparurent de nombreux biologistes amateurs, certainement les prédécesseurs des tenants de la biologie de synthèse « DIY » (do it yourself). Le magazine Popular Mechanics mentionne dès les années 1940 l’« ingénierie végétale moderne » et déclare ouverte l’ère des concepteurs de plantes par procédés chimiques. |

Génie génétique et biologie de synthèse De nombreuses autres avancées majeures marquent l’histoire de la biologie moléculaire dans la deuxième moitié du XXe siècle. Elles nous sont sans doute plus familières : la découverte de la structure de l’ADN ou encore le déchiffrage du code génétique. Je ne ferai que les évoquer rapidement pour me concentrer sur le développement des techniques de l’ADN recombinant dans les années 1970. Dès 1972, cette ère était décrite comme celle de la biologie de synthèse. Le design se proclamait la nouvelle caractéristique majeure : il était désormais possible de concevoir de nouvelles voies en associant des morceaux d’ADN. Cette nouvelle technique n’est qu’un nouvel avatar du génie génétique, appliqué ici à l’ADN recombinant plutôt qu’au comportement des chromosomes. Robert Sinsheimer (CalTech) écrit ainsi : « L’essence de l’ingénierie est la conception [...]. En matière de génie génétique, l’objectif est de pouvoir associer de façon arbitraire des fragments d’ADN. » Un autre son de cloche se fait toutefois entendre à la même époque. Malgré toutes les promesses de cette nouvelle ingénierie du vivant dans les années 1970, et trois décennies après la bombe atomique, les dangers potentiels de ces nouvelles techniques suscitent de larges inquiétudes. L’éminent biochimiste Erwin Chargaff s’interroge ainsi : « Avons-nous le droit de contrecarrer de manière irréversible la sagesse évolutionnaire de millions d’années pour satisfaire l’ambition et la curiosité de quelques scientifiques ? » |

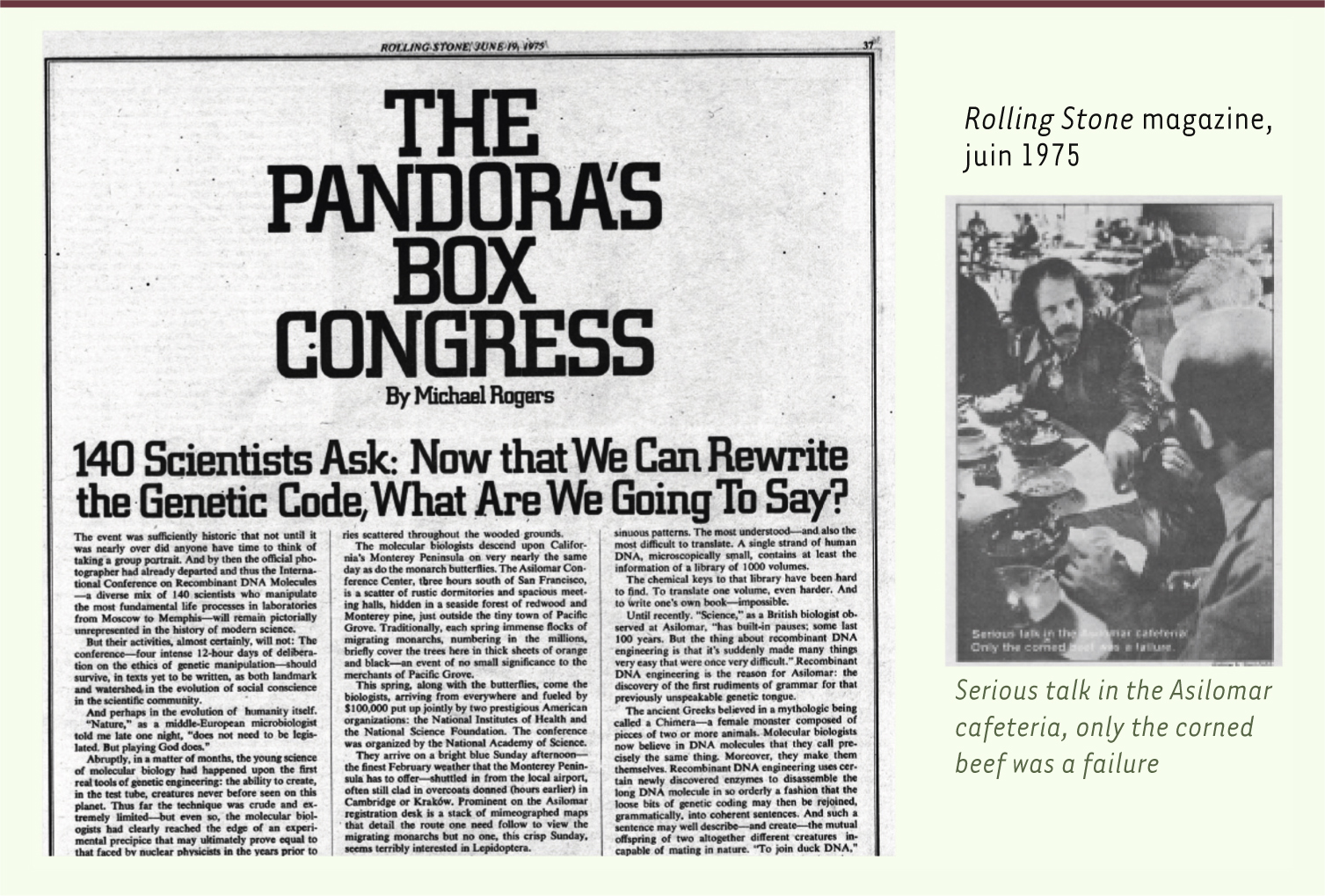

L’ADN recombinant était-il potentiellement dangereux pour la santé humaine ? Des scientifiques évoquèrent ces enjeux dans une série de lettres publiées au début des années 1970. Une conférence mondiale de grande envergure se tint à l’Asilomar Conference Center en Californie en 1975 pour débattre des éventuels problèmes de biosécurité. Le meilleur compte rendu de cette réunion - intitulée The Pandora’s Box Congress - a été écrite par un journaliste du magazine Rolling Stone (Figure 3).

| Figure 3.

The Pandora's box congress. Congrès de la « boîte de Pandore ». Conférence d’Asilomar (février 1975) appelant à un moratoire sur les manipulations génétiques. |

Alors que la génération précédente avait embrassé sans réserve les nouvelles technologies d’ingénierie du vivant, l’enjeu n’était pas aussi tranché pour certains scientifiques et pour le grand public dans les années 1970, et la prudence était de mise. Robert Sinsheimer écrit ainsi : « Nous pouvons mélanger des gènes aux origines les plus diverses à notre guise, de la plante à l’insecte, du champignon à l’homme. Nous devenons créateurs, producteurs de nouvelles formes de vie - des créations que nous ne pouvons défaire, qui survivront bien après nous, qui évolueront conformément à leur destin propre. Quelles sont les responsabilités de créateurs, pour nos créations et pour le monde vivant dans lequel nous introduisons nos inventions ? » Quoi que l’on en pense sur le fond, ce changement de vocabulaire, et notamment le retour du mot « création », en lieu et place du vocabulaire de l’ingénierie prôné par des figures scientifiques majeures, est très intéressant pour les historiens. Un autre changement important intervient à cette époque. Un terme plus général employé au début des années 1970 pour ce que nous appelons aujourd’hui génie génétique, c’est-à-dire les travaux sur l’ADN recombinant, était biologie de synthèse. Le terme génie génétique soulevait alors chez beaucoup la crainte de futures manipulations eugéniques chez l’homme. Cette perception semble avoir évolué à la fin des années 1970 : le terme biologie de synthèse, déjà peu commun, semble avoir disparu, alors que génie génétique était le terme le plus couramment employé. L’opinion publique vis-à-vis de ces nouvelles technologies était également plus divisée. Quand Time Magazine consacra une couverture au nouveau génie génétique en 1977, un débat s’éleva parmi les éditeurs pour savoir s’il fallait parler de « bidouillage » (tinkering) ou de « traficotage » (tampering) (Figure 4). Enfin, une industrie des biotechnologies s’était développée dans les années 1980, attirant d’importants capitaux et suscitant des développements commerciaux.

| Figure 4.

En avril 1977, le Time Magazine consacre sa Une de couverture au nouveau génie génétique.

|

|

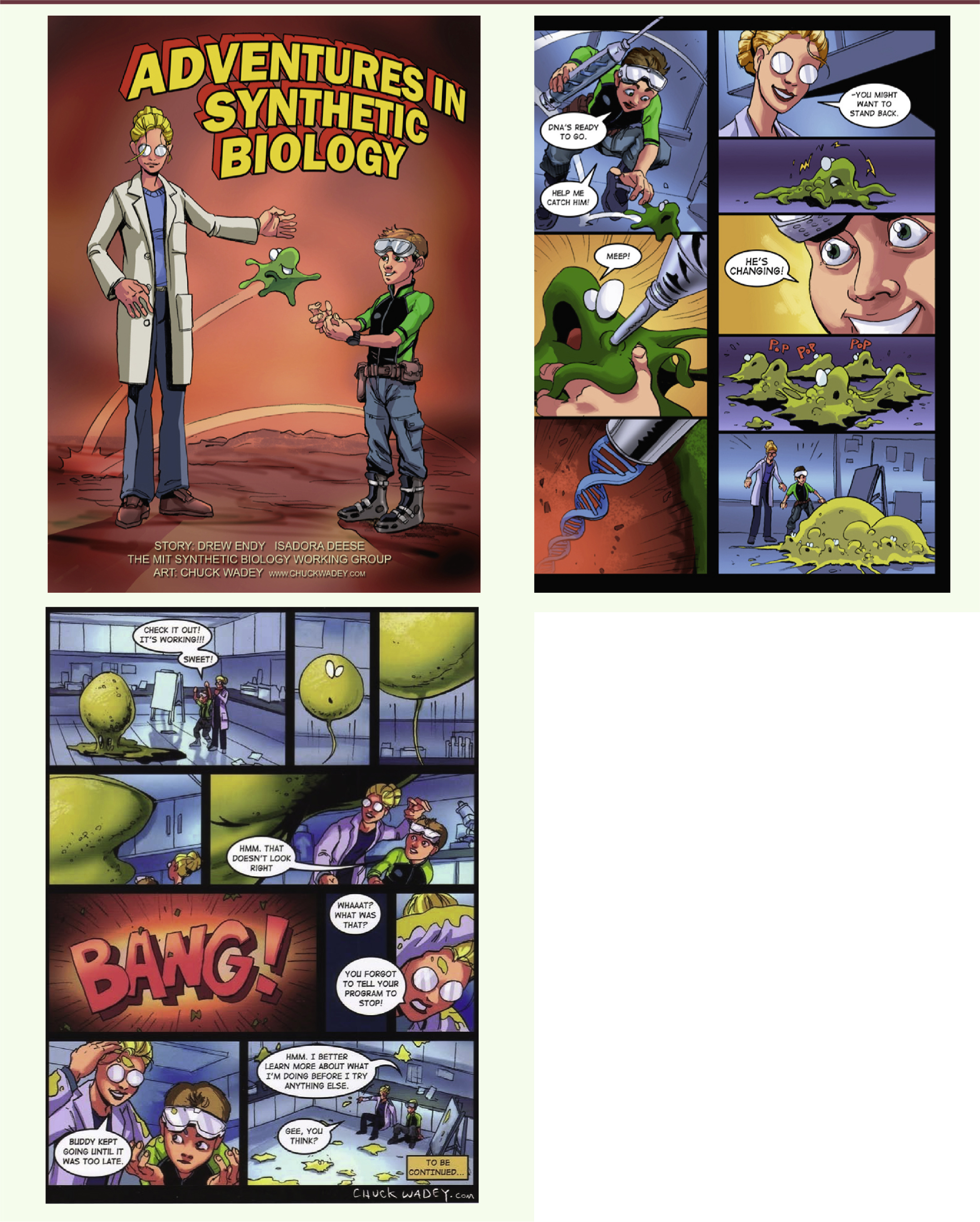

Années 2000 : un idéal d’ingénierie en biologie Il est toujours délicat de faire l’histoire du temps présent, mais une nouvelle génération apparut dans les années 2000, appelant de ses vœux l’introduction d’un idéal d’ingénierie en biologie. Pour ces chercheurs, la biologie était un processus brouillon que l’ingénierie pouvait rendre plus clair et plus simple. Cette avancée serait l’œuvre cette fois non seulement de biologistes, mais d’ingénieurs à proprement parler. Certains ressuscitèrent le vieux terme de biologie de synthèse, sans savoir d’ailleurs qu’il avait déjà existé par le passé, par analogie avec la chimie de synthèse. D’autres termes furent avancés, comme biologie intentionnelle ou biologie constructive, mais biologie de synthèse semble s’être imposé. Ces chercheurs avaient conscience que leurs travaux dépassaient le simple génie génétique. « Le génie génétique ne fait rien d’autre que des croisements », déclara-t-on au congrès Synthetic Biology 1.0 organisé par le MIT (Massachusetts Institute of technology) en 2004. La vraie ingénierie impliquait des principes, de la modularité, des prédictions, du contrôle, de la standardisation, une hiérarchie d’abstractions qui s’étend des composants aux dispositifs, en passant par les systèmes. Ce qui passait auparavant pour du génie génétique ne répondait donc pas à cette définition de l’ingénierie. Une nouvelle conception du génie génétique fut donc mise en chantier. Elle tira son inspiration de plusieurs sources, notamment les précédentes tentatives pour standardiser des composants de base, le développement de l’industrie informatique, l’éthique du mouvement du logiciel ouvert (open source), le vocabulaire et les manières de penser de l’informatique théorique. Ce champ fit l’objet dès ses débuts d’une intense médiatisation - via la publication de bandes dessinées ou l’organisation d’une compétition (iGEM, International genetically engineered machine competition) - piquant l’intérêt des étudiants de premier et deuxième cycle. Une bande dessinée, Adventures in synthetic biology [

1] fut même publiée dans le journal Nature, ce qui constitua certainement une première pour cette revue (Figure 5)

3.

| Figure 5.

La biologie de synthèse en bandes dessinées vue par The MIT synthetic biology working group [ 1] (textes de Drew Endy et dessins de Chuck Wadey - Ces images sont reproduites avec l’autorisation de Drew Endy et Chuck Wadey). Disponible via Creative commons ( http://openwetware.org/wiki/Adventures). |

Le deuxième congrès sur la biologie de synthèse à Berkeley, Californie, en 2006 accueillit le double de participants de la précédente édition ; les organisateurs durent même refuser du monde. Certaines associations de la société civile exprimèrent toutefois publiquement leurs inquiétudes vis-à-vis de ces nouvelles technologies et ce qu’ils pensaient être un manque de surveillance de la part des pouvoirs publics. Une attention accrue de la part du grand public et des subventions gouvernementales contribuèrent à développer l’intérêt pour cette discipline en Europe, en Amérique et en Asie. L’Union européenne et nombre de pays européens accrurent progressivement leur soutien financier à des projets de biologie synthétique et des projets de réflexion sur cette dernière. Au troisième congrès sur la biologie de synthèse qui s’est tenu à l’ETH Zürich (l’École polytechnique fédérale de Zurich), une association conçut même un poster exprimant ses vues. Chaque nouveau congrès - en 2008 à Hong Kong, en 2011 à Stanford, l’été prochain (2013) à Londres - est l’occasion de mettre en avant les progrès fascinants de la biologie de synthèse, mais soulève également des questions : comment développer une culture ouverte et responsable en la matière ? Comment intégrer les sciences humaines et sociales dans les projets de biologie de synthèse ? Comment réfléchir suffisamment aux implications plus larges - de nouveaux postes académiques, de nouvelles entreprises, de nouveaux débouchés d’investissement, peut-être un cadre réglementaire rénové et de nouvelles structures de gouvernance, un niveau d’intérêt croissant ? Le paysage compliqué de la biologie de synthèse n’est que le dernier avatar des efforts variés et vieux d’un siècle pour mieux comprendre la vie telle qu’elle est et concevoir de nouvelles formes de vie comme elles pourraient être. |

Des Lumières aux années 2000 : à chaque génération sa définition de la biologie de synthèse Nous nous interrogions à l’époque des Lumières face aux merveilles de l’hérédité et nous nous demandions quelles nouvelles créatures nous pourrions créer par hybridation. À la fin du XIXe siècle, nous entreprîmes avec succès de créer de nouvelles espèces de plantes et d’animaux que nul n’avait jamais vues auparavant, par la sélection comme par la mutation, en utilisant des rayons X et du radium. Au même moment fut inventé le terme mutant. L’expression biologie de synthèse émergea à cette époque, dans le cadre des efforts pour comprendre la nature de la vie, pour la contrôler et obtenir une « technologie de la matière vivante ». Les barrières entre le naturel et l’artificiel furent brisées. Dans les années 1930 à 1940, de nouvelles techniques utilisant les rayons X et des produits chimiques semblèrent rendre ce but plus proche : le génie génétique des chromosomes permit de produire à volonté de nouvelles espèces synthétiques. Il n’était plus nécessaire d’attendre que les mutations se produisent spontanément : il était désormais possible d’accélérer l’évolution avec des produits chimiques bien choisis ; ce fut à l’aide de l’ingénierie que l’on créa de nouvelles espèces. Dans les années 1970, le langage de la création et de la destruction devint plus problématique : mieux valait lui préférer celui de l’ingénierie. L’émergence d’une nouvelle technologie performante, l’ADN recombinant, révéla de nouvelles craintes dans l’ère post-Hiroshima : quels étaient les risques ? Était-ce du « bricolage » ou de la « falsification » ? S’agissait-il simplement de recombiner de l’ADN ou cela revenait-il à transgresser les barrières entre espèces ? Le grand public, qui avait accueilli avec enthousiasme les nouvelles fleurs et nouveaux fruits créés par les « magiciens des plantes » au début du XXe siècle, se raccrochait à l’avis de scientifiques recommandant la prudence vis-à-vis des dangers d’apprentis sorciers. Comment pouvait-on assurer un développement responsable du génie génétique ou de la biologie de synthèse ? Se dirigeait-on vers un nouvel eugénisme ? Dans les années 2000, les techniques de l’ADN recombinant furent dépassées à leur tour, et considérées comme insuffisamment basées sur des principes d’ingénierie. Le but n’était pas celui d’un créateur démiurge aux ressources illimitées et au pouvoir presque divin, mais celui de projets d’ingénierie définis, conçus sur la base de budgets et de contraintes réalistes. Il ne s’agissait plus simplement de faire marcher quelque chose, mais de comprendre pourquoi, prédire ses fonctions, le modéliser, le standardiser et le distribuer - conduire les biotechs dans l’intérêt du public, sauver le monde par la promesse de nouvelles solutions synthétiques, industrialiser et commercialiser, ou encore s’y adonner seul dans son garage. Malgré toutes les évolutions de la biologie de synthèse, l’objectif d’atteindre une « technologie de la matière vivante », que nous décrivons volontiers aujourd’hui comme « la biologie comme une technologie », semble avoir perduré. Il semble que chaque génération doive se débrouiller par elle-même pour découvrir ce que veut dire la biologie de synthèse et comment la mener. |

L’auteur déclare n’avoir aucun lien d’intérêt concernant les données publiées dans cet article.

|

Claire Marris Les trois intervenants ont mentionné des changements d’esprit. François Képès a énuméré plusieurs étapes dans cette nouvelle conception de la biologie ; la dernière étape, la biologie de synthèse, serait une conception rationnelle. Or selon Luis Campos, nous parlons depuis cent ans au moins de conception rationnelle, de normalisation, de standardisation et de création de nouvelles espèces à volonté. Thomas Heams a également montré que cette promesse d’une ingénierie du vivant peut mener à une désillusion. À quel point la biologie de synthèse marque-t-elle un changement d’état d’esprit et de méthodes ? Thomas Heams Ce changement d’état d’esprit est aussi la prise de conscience de ce que nous sommes capables de faire. Selon François Képès, la biologie de synthèse se développe à la suite du triomphe de la biologie analytique et des « -omiques ». Ce point de vue mérite discussion : les -omiques sont productrices de données, au point que nous pouvons être ensevelis sous elles. La biologie analytique n’est donc pas réellement triomphante. La biologie de synthèse a produit de très beaux cas d’école, comme des modifications massives du génome par l’insertion de 5, 10, voire 18 gènes. Elle l’a fait par design rationnel, mais souvent en faisant appel aux principes d’une biologie analytique volontiers décrite comme dépassée, notamment l’évolution dirigée de molécules et de cellules. De même, le concours iGEM propose de produire à partir de bio-briques, mais il s’agit plutôt de preuves de principe, et non de recherches menées à leur terme. Il faut donc rester mesuré sur la capacité à agir rationnellement. François Képès Nous avons affaire à une boucle de rétroaction : la technologie ouvre des possibilités qui poussent les chercheurs à rêver d’introduire un degré de rationalité supérieur. En retour, le caractère plus accessible de cet idéal a réorienté certaines lignes de recherche, entraînant des progrès. Ces derniers seront plus longs à s’opérer que le changement d’état d’esprit, mais ils sont d’ores et déjà tangibles depuis une dizaine d’années. Cette boucle est permise grâce à l’échec plein de succès que j’évoquais précédemment : l’échec de l’ingénieur permet de progresser au plan de la compréhension fondamentale et bâtit le succès du deuxième ou du troisième essai. Pour réagir aux propos de Thomas Heams, il ne s’agit pas de placer des organismes dans un fermenteur pour les laisser évoluer : un design rationnel est établi à chaque fois, qui permettra à la cellule d’aller dans la direction souhaitée. Le design rationnel préside donc à l’évolution, laquelle cherche des solutions dans un espace considérable et en trouve qui ne sont pas toujours optimales, mais sont acceptables vis-à-vis de l’objectif recherché. Ceci n’est possible que si les conditions ont été définies rationnellement. Luis Campos Il est fascinant de constater que le but n’a guère varié au cours du temps : il s’agit d’améliorer le monde en construisant de nouvelles choses. Même si l’on parle parfois de révolution, chaque génération sait qu’elle bâtit sur les connaissances acquises par les précédentes. Cette tension entre volonté de faire du neuf, conscience des acquis précédents et importance de la découverte fortuite est particulièrement intéressante. Pierre Monsan On ne peut faire de l’ingénierie que de ce qu’on maîtrise rationnellement. à partir de quand le génie épigénétique sera-t-il envisageable ? François Képès Nous en voyons déjà les prémices. Cependant il est plus facile de chercher ce dont on connaît la localisation et qu’on peut ramener à une suite de lettres A, T, G, C, ce qui a été fait pour le décodage du génome, que d’appréhender un phénomène complexe. Le génie épigénétique existe au sens où après installation d’un circuit de régulation - comme un oscillateur ou un interrupteur - dans une cellule et division cellulaire, l’oscillateur des cellules filles hérite directement de l’état qu’il avait dans la cellule mère. L’information n’est pas d’ordre génétique, mais épigénétique. L’expérience publiée en 2000 par Leibler d’un oscillateur entretenu dans les bactéries vivantes est ainsi un petit succès de l’ingénierie épigénétique. L’ingénierie épigénomique est en revanche beaucoup plus complexe. Elle ne devrait pas aboutir dans les dix ans à venir. Jean-François Toussaint Luis Campos a rappelé le grand drame de la philosophie prométhéenne qui parcourt la biologie de synthèse depuis sa naissance. Vous avez montré l’analogie avec les étapes précédentes - il nous reste quelques décennies pour résoudre les problèmes accumulés par la chimie de synthèse et ses produits secondaires non recyclés. La nature est fractale : il faut reproduire à tous les niveaux quelque chose qui ajoute de la complexité sur l’ensemble des étapes, que ce soient les bio-briques, les systèmes ou les cellules. Une partie de la sélection en dépend, or ENCODE1, a apporté une couche de complexité supplémentaire dans l’hypothèse de la reine rouge2. Comment introduire le fractal dans la biologie de synthèse ? François Képès La sélection agit effectivement non seulement au niveau de l’individu, mais aussi en deçà et au-delà, par exemple au niveau de la population. Il est certainement raisonnable de proposer des approches rationnelles à ce sujet, mais je ne suis pas spécialiste de ces questions. Pour prendre un exemple, il a été proposé que le bruit - la fluctuation de la valeur des paramètres au cours du temps - dans les systèmes biologiques pouvait jouer un rôle favorable au niveau de la population, alors qu’il peut jouer un rôle défavorable au niveau moléculaire. Pour prendre un exemple, le phage lambda, un virus bactériophage, comporte un interrupteur génétique entre deux voies de différenciation, le cycle lytique et la croissance lysogénique. Ce choix développemental se fait en fonction de l’état de la cellule hôte. Selon Adam Arkin (1998), le système comporte du bruit : quand on active l’interrupteur dans une population, 5 % des individus ne répondent pas et ont vocation à disparaître. Si toutefois les conditions retournent très vite à la situation précédente, les 95 % de la population ayant fait le choix a priori le plus adapté mourront ; les 5 % dus au bruit du système permettront à la population d’être préservée. Le bruit peut donc être vu de manière très différente au niveau d’une population ou d’une cellule. Je n’ai pas de réponse à votre question au-delà. Thomas Heams Je ne suis pas non plus spécialiste. Des travaux de biologie de synthèse portent sur des consortiums bactériens : plutôt que de modifier massivement une seule espèce bactérienne, les modifications sont réparties sur plusieurs. Cette approche repose sur le constat qu’aucune espèce bactérienne ne vit seule, sauf dans des biotopes très particuliers. Elle fait ainsi entrer l’écologie dans la biologie de synthèse. Dorothée Benoit-Browaeys Une certaine contradiction apparaît entre l’exposé de François Képès et celui de Luis Campos. Le premier montre que l’ingénieur procède par essai et erreur, en raison de la résistance du vivant - on peut peut-être parler de « bricolage » du vivant. Inversement, l’exposé de Luis Campos montre que l’idée de maîtrise est la perspective majeure, comme le montrent les propos de Jacques Loeb. Il est intéressant d’examiner cette situation sous l’angle du contrat social : que présenter à la société du projet de la biologie de synthèse ? S’agit-il de contrôler des organismes vivants, par exemple pour la production énergétique de molécules chimiques dans le contexte de la fin du pétrole ? L’écart entre les deux exposés montre que ce rêve de maîtrise ne correspond pas à la réalité. Ne doit-on pas réfléchir alors à ce qu’impose le vivant comme redéfinition du métier d’ingénieur ? Le « technomimétisme », c’est-à-dire l’idée que la technique restera telle quelle, n’est-il pas confronté au « biomimétisme » ou à la « bio-inspiration », c’est-à-dire une autre manière d’envisager l’intervention humaine sur le monde, avec une technologie située et humaine ? À l’instar de la médecine personnalisée, nous aurions une technologie personnalisée, adaptée aux situations et aux demandes sociales. Luis Campos On dit souvent que la technologie devance la société, qui doit alors rattraper son retard. L’historien des sciences s’intéresse plutôt à la manière dont on peut comprendre les nouvelles technologies au moment de leur émergence et à la manière dont elles reflètent les ambitions et intérêts de la société. En l’occurrence, ces nouvelles formes d’intervention peuvent témoigner de changements plus grands dans nos pratiques culturelles que de simples avancées technologiques. François Képès La principale différence entre l’exposé de Luis Campos et le mien tient à l’échelle de temps : je ne suis pas historien. Je témoigne des avancées des quinze ou vingt dernières années, que j’ai pu voir moi-même, alors que Luis Campos s’inscrit dans une vision à beaucoup plus long terme. La technologie humaine et personnalisée ne deviendra possible que lorsque nous disposerons de moyens à plus petite échelle de production et notamment de bioproduction. Le schéma qui prévaut aujourd’hui porte sur la production massive, par exemple du paracétamol ou du vaccin contre l’hépatite B par la levure. Il doit persister, car il constitue une bonne solution dans ce genre de situation. Toutefois, les maladies immunitaires - allergies ou maladies auto-immunes - deviennent beaucoup plus prégnantes dans la population : elles requièrent des traitements parfois individuels. Ensuite, les grandes maladies comme le cancer d’un organe se subdivisent peu à peu, grâce à un diagnostic moléculaire plus précis, en maladies ayant chacune une approche thérapeutique et un pronostic différents. Le traitement ne s’adressera plus à des dizaines de millions de patients, mais à cent personnes, voire dix ou même une seule. Il ne s’agit pas de produire des médicaments à la tonne, mais d’inventer de nouvelles façons de faire. La biologie de synthèse apporte des embryons de solutions dans ce sens. La petite production, presque individualisée, est envisageable sur le plan technologique et technique. Elle ne débouchera toutefois sur des innovations et des résultats concrets que si la société civile en décide, notamment au travers de son positionnement vis-à-vis des grands laboratoires que cette aventure ne tentera pas nécessairement. Jacques Haiech Vous n’avez pas évoqué l’enjeu de la formation dans ce qui a été décrit comme une discipline émergente. Quel pourrait être l’obstacle à l’intégration d’un questionnement sociétal, scientifique et ingénieurial dans la formation des étudiants ? Thomas Heams AgroParisTech, où j’enseigne, a pour devise « les ingénieurs du vivant ». La biologie de synthèse a comme atout de mener une pédagogie active vis-à-vis des étudiants, au travers notamment des programmes d’iGEM. Ce champ suscite beaucoup d’enthousiasme : tout semble devenir possible avec une machine de PCR et quelques enzymes - il faut garder les pieds sur terre. Enseignant dans une école d’agronomie, je suis confronté à des enjeux de pédagogie importants. Il faut d’abord insister sur la compréhension des conséquences de ses actes : à intervention massive, responsabilité massive à toutes les échelles. La biologie des systèmes est intéressante à cet égard en tant que pensée systémique. Luis Campos La biologie de synthèse a la particularité de rassembler différents groupes et modes de connaissances : les scientifiques cherchent des réponses ; les ingénieurs cherchent des solutions ; les historiens racontent des histoires et souvent cherchent de nouvelles questions. Jean-Pierre Alix Vous n’avez pas encore évoqué la dimension économique : l’évolution vers des traitements de plus en plus individualisés implique aussi une augmentation du coût des traitements, non maîtrisable dans la plupart des pays développés. Soigner une maladie orpheline multiplie ainsi les coûts individuels par dix, cent ou mille. Le problème que nous discutons est donc contingent des conditions économiques générales. François Képès Vous avez tout à fait raison. Des méthodes de génie biologique avancé comme la biologie de synthèse peuvent toutefois permettre une diminution drastique des coûts à plus ou moins long terme. Une telle évolution requerra un débat au sein de la société civile. La biologie de synthèse n’est pas non plus dépourvue d’intérêt du point de vue de la production massive : il faudra produire massivement des machines capables de produire en petites quantités, basées a priori sur des principes de génie technologique autorisant la micro-production locale de médicaments ou de vaccins. Marc Fellous Les bio-briques sont-elles uniquement des nucléotides ou peuvent-elles être des acides aminés ? Ensuite, le but est-il de reproduire des fonctions existantes ou de nouvelles fonctions qui n’existaient pas auparavant ? Enfin, ces fonctions sont-elles biologiques ou peuvent-elles être auto-réplicantes, comme l’ADN ? Thomas Heams Telles qu’elles sont définies dans le concours iGEM organisé par le MIT et destiné aux étudiants, les bio-briques sont des séquences d’ADN. Il ne s’agit pas toujours de reproduire des fonctions existantes : on peut faire clignoter des bactéries ou les faire se répondre en synchronie. Certaines fonctions sont internes à la bactérie. Des équipes françaises ont également proposé des bactéries solidaires les unes des autres permettant de penser, au-delà d’une fonction spectaculaire dans une seule entité, la connexion qui peut exister entre les différentes formes de vie. Cela peut donc mener à la compréhension des mécanismes plus généraux et parfois plus fins. |

Footnotes |

1.

Endy

D

,

Deese

I.

The MIT synthetic biology working group . Nature.

2005; ; 438 : :449.–453. |