| |

| Med Sci (Paris). 2008 December; 24(12): 1061–1064. Published online 2008 December 15. doi: 10.1051/medsci/200824121061.Rythmes corticaux endogènes et spécialisation fonctionnelle du langage Anne-Lise Giraud* Inserm U742, Département d’Études Cognitives, École Normale Supérieure, 46, rue d’Ulm,75005 Paris, France |

La théorie motrice du « Frame/Content» Du côté moteur, la théorie du « Frame/Content » de Peter MacNeilage et Barbara Davis [

1–

5] propose que les traits élémentaires de la parole humaine soient déterminés par les propriétés mécaniques de l’appareil phonatoire, en particulier par ses rythmes d’oscillations spontanés. Ainsi, le rythme syllabique de la parole correspond à la fréquence caractéristique d’oscillation de la mâchoire (environ 4 Hz). Les différents phonèmes consonantiques sont produits par différentes positions de la langue dans la cavité buccale et, de fait, la cadence phonémique (la longueur moyenne d’un phonème) est limitée par les capacités de déplacement de la langue dans la cavité buccale (environ 25-40 Hz). Le découpage de la parole en unités syllabiques et phonémiques pourrait donc refléter l’optimisation des performances motrices de l’appareil phonatoire. |

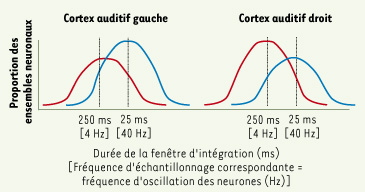

La théorie de l’échantillonnage asymétrique Du côté perceptif, la théorie de l’échantillonnage asymétrique (asymmetric sampling in time, AST) de David Poeppel [5–

7] propose que le cerveau humain soit équipé de deux systèmes d’échantillonnage, qui permettent de découper le signal acoustique de parole en unités de base, les syllabes et les phonèmes. On sait que les cortex auditifs droit et gauche ont un contenu cellulaire sensiblement différent [

8,

9]. Le cortex auditif gauche possède plus de grandes cellules pyramidales, dont l’activité électrique oscillatoire spontanée se situerait autour de 40 Hz [

10]. Le cortex auditif droit en possèderait moins, mais contiendrait une plus grande proportion de cellules plus petites, présentant une activité oscillatoire plus lente, autour de 4 Hz. La théorie AST (Figure 1) propose que les propriétés oscillatoires de ces neurones servent d’échantillonneur adaptatif ; l’alignement entre les oscillations spontanées et le rythme du signal de parole pourrait renforcer un mode de réponse périodique des neurones ayant comme conséquence le découpage du flux auditif continu en « paquets » d’informations. Ces paquets d’informations auraient ainsi le bon « format » pour entrer en contact avec des « représentations » linguistiques stockées en mémoire, les phonèmes, les syllabes, les mots. Le cortex auditif gauche, contenant plus de cellules « rapides », serait plus à même que le cortex droit d’offrir un mode de découpage phonémique de l’information auditive. Il serait donc plus sensible que le droit aux éléments linguistiques de base, les phonèmes, ce qui expliquerait sa spécialisation dans le traitement de la parole. Le cortex droit, en étant moins sensible à l’information phonémique, serait plus sensible à un type d’information acoustique plus lent, plus stationnaire, comme les indices vocaux qui varient peu quel que soit le mot prononcé.  | Figure 1.

Théorie de l’échantillonnage asymétrique. Le cortex auditif gauche contriendrait plus de cellules oscillant rapidement que le droit, et réciproquement le droit plus de cellules oscillant lentement que le gauche. |

|

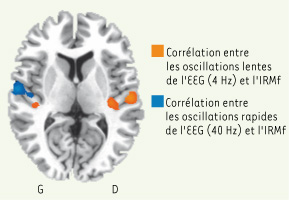

Corrélation entre l’activité corticale électrique de surface et la réponse hémodynamique L’asymétrie des cortex auditifs dans l’expression d’oscillations spontanées restait à démontrer empiriquement. Grâce à l’enregistrement simultané de l’EEG (électroencéphalogramme) et de l’IRMf (imagerie par résonance magnétique fonctionnelle) chez des sujets au repos, nous avons pu localiser précisément les substrats neuronaux dont l’activité hémodynamique (IRMf) covarie au cours du temps avec l’activité électrique (EEG) enregistrée sur leur scalp pendant environ 30 minutes [

11]. Au cours de ces 30 minutes de repos, chaque participant exprime individuellement les différents rythmes classiques de l’activité corticale. Les rythmes gamma et thêta sont ceux qui nous intéressent, car ils recouvrent les bandes de fréquences qui correspondent précisément à la théorie AST, c’est-à-dire la bande 3-6 Hz (thêta) et la bande 28-40 Hz (gamma). Les fluctuations lentes de l’activité électrique dans chacune de ces bandes de fréquence ont été extraites et mises en relation avec les fluctuations de l’activité hémodynamique mesurée en IRMf. Nous obtenons ainsi une cartographie précise du niveau de corrélation entre les deux mesures. Nous avons constaté que les régions dont l’activité hémodynamique corrélait le plus fortement avec l’activité thêta étaient le cortex auditif droit, le cortex temporal antérieur gauche, le cortex prémoteur et l’aire motrice supplémentaire. L’activité gamma était associée à l’activité hémodynamique des cortex sensoriels auditifs et visuels, et des cortex moteurs. Dans les cortex auditifs, nous avons observé plus d’activité gamma du côté gauche, et plus d’activité thêta du côté droit (Figure 2). Ces données expérimentales confirment les hypothèses de l’AST, et suggèrent donc une supériorité gauche pour l’analyse phonémique.  | Figure 2.

Cartographie de la corrélation entre les fluctuations lentes de l’EEG dans les bandes thêta et gamma et les fluctuations de l’activité hémodynamique spontanée (IRMf).

|

|

Le rythme thêta : à droite-à gauche La topographie de l’activité thêta soulève cependant quelques questions. Le rythme thêta s’exprime non seulement dans le cortex auditif droit mais aussi dans le cortex temporal antérieur gauche, qui est responsable de traitements auditifs et linguistiques plus avancés, et dans lequel certains auteurs ont trouvé une organisation topographique des syllabes et phonèmes [

12,

13]. La localisation de l’activité thêta dans cette région pourrait souligner le rôle « associatif » de ce rythme. L’information auditive de parole pourrait être échantillonnée à une cadence rapide au niveau du cortex auditif, et les « paquets » d’information phonémique ainsi constitués pourraient ensuite être regroupés en « paquets » plus grands, des syllabes, dans les régions auditives associatives grâce aux oscillations dans la bande thêta. Cette interprétation mérite confirmation, mais elle est compatible avec la notion classique que la parole est traitée majoritairement par l’hémisphère gauche. Nos données sont aussi compatibles avec les observations d’autres auteurs qui montrent une modulation des rythmes gamma par le rythme thêta dans le cortex temporal humain grâce à des enregistrements intracrâniens [

14]. L’hypothèse AST d’une localisation du rythme thêta majoritairement dans le cortex auditif droit soulève le problème du regroupement des informations segmentales (phonèmes) et suprasegmentales (syllabes, mots). Le regroupement des phonèmes en unités plus longues (syllabes, mots) pourrait se faire grâce au rythme thêta exprimé dans le lobe temporal gauche. En effet, il serait très coûteux pour le cerveau de traiter l’information phonémique à gauche et l’information syllabique à droite, puisqu’il lui faudrait ensuite rassembler les deux types d’information par des connexions interhémisphériques. Nos résultats semblent indiquer que ce n’est pas nécessairement le cas et que le traitement linguistique segmental et suprasegmental pourrait se faire entièrement à gauche. |

À quoi sert le rythme thêta dans le cortex auditif droit ? Le rythme thêta pourrait contribuer à une analyse linguistique suprasegmentale de type « globale » à droite. Cette idée est compatible avec le constat que les personnes qui réapprennent à comprendre la parole avec un implant cochléaire, commence par « écouter » la parole avec leur cortex auditif droit avant de re-latéraliser les traitements linguistiques à gauche au bout de plusieurs mois [

15]. Ces personnes ré-apprennent à entendre les contours avant de percevoir plus précisément la structure phonémique. En revanche, chez les sujets normo-entendants, il est très rare d’observer une dominance droite dans le traitement linguistique, sauf quand le sujet focalise son attention sur la mélodie globale de la parole (la prosodie). Le cortex temporal droit est surtout impliqué dans la perception de la voix humaine, des sons de l’environnement et de la musique [

16,

17]. Il est donc plus logique de chercher un rôle pour le rythme thêta à droite dans le séquençage et l’intégration des stimulus acoustiques non-linguistiques. En l’absence de prédécoupage « phonémique » dans le cortex auditif droit, le rythme thêta intégrerait l’information auditive sur une assez longue fenêtre temporelle (environ 200 ms). Cette longue fenêtre d’intégration ne permettrait pas la détection des variations rapides du signal acoustique, mais permettrait au contraire l’extraction des « invariants », comme les indices de vibration périodique des cordes vocales, caractéristiques de chaque locuteur et, plus généralement, l’extraction de ce qui varie lentement dans les signaux acoustiques courants, comme la prosodie de la parole ou les rythmes musicaux. |

Gamma et thêta dans le cortex moteur Nos données expérimentales montrent que l’activité électrique corticale dans la bande de fréquence thêta covarie avec l’activité hémodynamique dans la région prémotrice de la bouche, et que l’activité gamma covarie avec celle de la région de la langue. La théorie « Frame/Content » souligne que le stimulus de parole est formaté par les capacités du système moteur. Il est donc intéressant d’observer un recouvrement entre le rythme syllabique et la région de la bouche, et entre le rythme phonémique et la région de la langue. Ces observations sont cependant à pondérer, car chacune des deux bandes de fréquence est associée à l’activité hémodynamique de plusieurs régions motrices. Le rôle d’une activité oscillatoire spontanée dans la région prémotrice des structures phonatoires ne faisait pas l’objet d’hypothèses précises. On peut cependant supposer que les rythmes prémoteurs participent au formatage des signaux articulatoires. De plus, l’alignement des rythmes de la perception dans les cortex auditifs et des rythmes de la production dans les cortex moteurs pourrait constituer un processus physiologique par lequel la perception et la production de la parole se seraient mutuellement contraintes au cours de l’évolution du langage chez l’homme. |

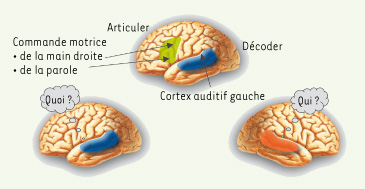

La bouche, la langue et la main Si nous commençons à comprendre les mécanismes physiologiques de la spécialisation fonctionnelle gauche pour le langage chez l’homme, on ne s’explique pas encore comment l’évolution a abouti à une organisation latéralisée pour le traitement du langage. L’organisation fonctionnelle chez d’autres espèces animales fournit néanmoins quelques pistes. De nombreuses espèces animales présentent une asymétrie droite-gauche dans le traitement auditif. Une asymétrie constitutive du système auditif précède donc l’apparition du langage et sa latéralisation à gauche [

18]. Gentilucci et Corballis [1] proposent que la parole ait évolué à partir de gestes manuels. Ainsi, au traitement latéralisé des signaux acoustiques et des vocalisations, se serait rajouté chez le primate une gestuelle de la main droite qui aurait renforcé la latéralisation gauche des processus du langage (la commande motrice de la main droite provient de l’hémisphère gauche, Figure 3). Le langage émanerait, selon ces auteurs, de la mobilisation du complexe main/bouche au départ dans le contexte de l’alimentation. L’autonomisation de la parole serait plutôt intervenue tard dans l’évolution, peut-être à la faveur de mutations permettant l’articulation, par exemple celle du gène FOXP2 survenue bien après l’apparition de H. sapiens sapiens. Cette théorie demeure spéculative, mais nos résultats empiriques ne sont pas incompatibles avec cette vue, puisque nous observons que l’activité corticale correspondant aux différentes bandes de fréquence d’oscillation critiques pour la perception et la production de la parole s’étend aussi (à des seuils statistiques plus bas) aux régions motrices de la main.  | Figure 3.

La spécialisation hémisphérique gauche pour le langage proviendrait du couplage entre la dominance gauche pour le traitement des événements acoustiques rapides (à l’origine de la perception du « quoi » dans la parole) et la gestuelle de la main droite accompagnant les vocalisations.

|

|

L’enregistrement simultané de l’EEG et de l’IRM fonctionnelle a permis de mettre en évidence une topographie particulière de l’expression corticale endogène des rythmes de la parole humaine, soulignant l’interaction mutuelle entre perception et production de parole. Avec cette même technique, nous pourrons peut-être à l’avenir identifier d’éventuels dysfonctionnements constitutionnels de l’activité oscillatoire corticale dans les pathologies classiques de la communication, telles que l’autisme infantile et la dyslexie. Cette étape serait essentielle pour faire le lien entre l’origine génétique de ces pathologies et leur expression clinique. |

1. Gentilucci M, Corballis MC. From manual gesture to speech: A gradual transition. Neurosci Biobehav Rev 2006; 30 : 949–60. 2. Liberman AM, Whalen DH. On the relation of speech to language. Trends Cogn Sci 2000; 4 : 187–96. 3. MacNeilage PF, Davis BL. On the origin of internal structure of word forms. Science 2000; 288 : 527–31. 4. MacNeilage PF, Davis BL. Motor mechanisms in speech ontogeny: phylogenetic, neurobiological and linguistic implications. Curr Opin Neurobiol 2001; 11 : 696–700. 5. Poeppel D. The analysis of speech in different temporal integration windows: cerebral lateralization as asymmetric sampling in time. Speech Communication 2003; 41 : 245–55. 6. Boemio A, Fromm S, Braun A, Poeppel D. Hierarchical and asymmetric temporal sensitivity in human auditory cortices. Nat Neurosci 2005; 8 : 389–95. 7. Luo H, Poeppel D. Phase patterns of neuronal responses reliably discriminate speech in human auditory cortex. Neuron 2007; 54 : 1001–10. 8. Hutsler J, Galuske RA. Hemispheric asymmetries in cerebral cortical networks. Trends Neurosci 2003; 26 : 429–35. 9. Dorsaint-Pierre R, Penhune VB, Watkins KE, et al. Asymmetries of the planum temporale and Heschl’s gyrus: relationship to language lateralization. Brain 2005; 129 : 1164–76. 10. Gray CM, McCormick DA. Chattering cells: superficial pyramidal neurons contributing to the generation of synchronous oscillations in the visual cortex. Science 1996; 274 : 109–13. 11. Giraud AL, Kleinschmidt A, Poeppel D, et al. Endogenous cortical rhythms determine cerebral specialisation for speech perception and production. Neuron 2007; 56 : 1127–34. 12. Rauschecker JP, Tian B. Mechanisms and streams for processing of what and where in auditory cortex. Proc Natl Acad Sci USA 2000; 97 : 11800–6. 13. Obleser J, Boecker H, Drzezga A, et al. Vowel sound extraction in anterior superior temporal cortex. Hum Brain Mapp 2006; 27 : 562–71. 14. Canolty RT, Edwards E, Dalal SS, et al. High gamma power is phase-locked to theta oscillations in human neocortex. Science 2006; 313 : 1626–9. 15. Giraud AL, Truy E, Frackowiak R. Imaging plasticity in cochlear implant patients. Audiol Neuro-Otol 2001; 6 : 381–93. 16. Fecteau S, Bedard C. Thinking the voice: neural correlates of voice perception. Trends Cogn Sci 2004; 8 : 129–35. 17. Peretz I, Zatorre RJ. Brain organization for music processing. Ann Rev Psychol 2005; 56 : 89–114. 18. Voss HU, Tabelow K, Polzehl J, et al. Functional MRI of the zebra finch brain during song stimulation suggests a lateralized response topography. Proc Natl Acad Sci USA 2007; 104 : 10667–72. |